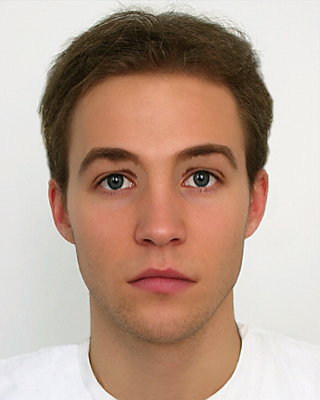

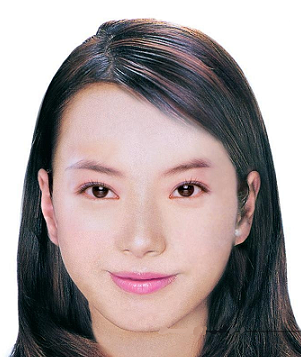

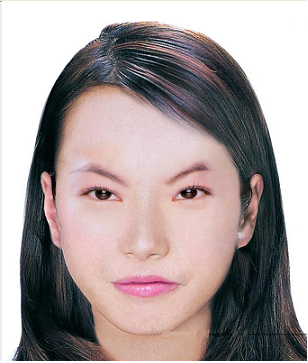

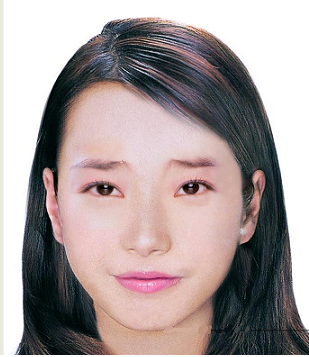

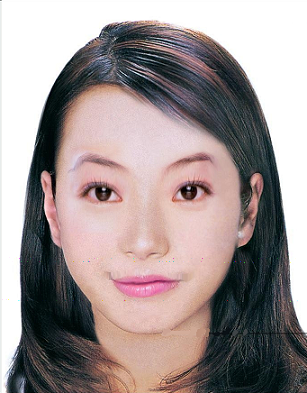

實驗結果

正常

喜

怒

哀

驚訝

互動式人臉表情系統

指導教授:楊傳凱

|

簡介 |

|

在計算機圖學的領域中有關如何合成、產生人臉表情,一直是個很有趣但也很困難及複雜的問題,其解決的方法也是千奇百怪。例如有人透過考慮表情與臉部肌肉及頭骨結構之間的密切關係,利用3D人臉模型來做變形。另一種常見的解決方法係採用MPEG4的SNHC(Synthetic Natural Hybrid Coding)來對人臉上的五官分別作詳細的定義與編碼。 在本論文中,我們提出了一個人臉表情互動式系統,使用者只需要將他的個人照(大頭照)輸入系統中,就能在短時間內產生出具有各種不同使用者表情的照片輸出;在此過程中使用者僅需以手動方式先標出五官的粗略位置,接著系統會透過「主動式輪廓法」(Active Contour)來準確地抓到眼睛、眉毛、嘴巴輪廓上的控制點座標,然後再進行變形,過程當中並會使用到「雙線性內插法」(Bilinear Interpolation)以產生出喜、怒、哀、樂等表情的動畫。 在本論文的最後,我們又搭配一個音樂分析處理系統,簡單地說就是分析在音樂當中的特徵,例如 曲調的高低、節奏的快慢等,以判斷出一首歌曲在不同段落的喜怒哀樂風格,並加入上述所合成出的個人化表情,使得我們能依照一首歌曲當中不同音樂風格的段落來同時展現出不同的人臉表情。

|

|

實驗結果 |

||||

|

正常 |

喜 |

怒 |

哀 |

驚訝 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

實驗結果(影片) |

|

| 系統操作流程 | |

| 最終系統 | |

|

檔案下載 |